Конституцию США написали нейросети: теория заговора или глупая ошибка

Почему детекторы генеративного текста до сих пор не способны точно выполнить поставленную задачу?

Как определить, написан ли текст человеком или искусственным интеллектом? Этот вопрос становится всё более актуальным в свете развития технологий генерации текста, которые могут создавать убедительные и реалистичные тексты на любую тему.

В США, например, чрезмерно подозрительные преподаватели уже не раз ложно обвиняли студентов и школьников в использовании генеративных нейросетей и, как следствие, нечестно выполненной работе, что приводило к многочисленным скандалам, растущему недоверию и напряжённости в образовательной сфере.

Существует уже целый ряд сервисов и инструментов, способных довольно точно, по заявлению авторов, определить, был ли текст сгенерирован нейросетью или написан человеком. Среди таких сервисов, например, GPTZero, ZeroGPT и OpenAI Text Classifier. Однако, как оказалось, и на эти сервисы всерьёз полагаться не стоит.

Так, исследование, проведённое исследователями из Университета Мэриленда и опубликованное в марте этого года, эмпирически продемонстрировало, что детекторы текста, сгенерированного искусственным интеллектом, ненадёжны в практических сценариях.

Помимо того, что подобным инструментам свойственны ложные срабатывания на текст, полностью написанный человеком, так их ещё и легко обмануть, попросив тот же условный ChatGPT поменять порядок слов в предложении без искажения смысла, или сделать предложения и абзацы разной и чередующейся длины. Такие уловки очень быстро запутывают любого рода детекторы.

Примерно в то же время аналогичный эксперимент провели исследователи из Стэнфордского университета, также сделав результаты своей работы достоянием общественности. Они выяснили, что детекторы предвзято относятся к лицам, не являющимися нативными носителями английского языка, что приводит к высокому уровню ложноположительных результатов при проверке их текстов.

Одним из самых забавных фактов о детекторах ИИ-текстов стало недавнее открытие. Оказывается, оригинальный текст Конституции США, загруженный в детектор ZeroGPT без изменений, — с точностью в 96,21% определяется как сгенерированный нейросетью. И если Джеймс Мэдисон, один из основных авторов оригинальной американской Конституции, не был путешественником во времени, то в работе детекторов явно есть определённые огрехи.

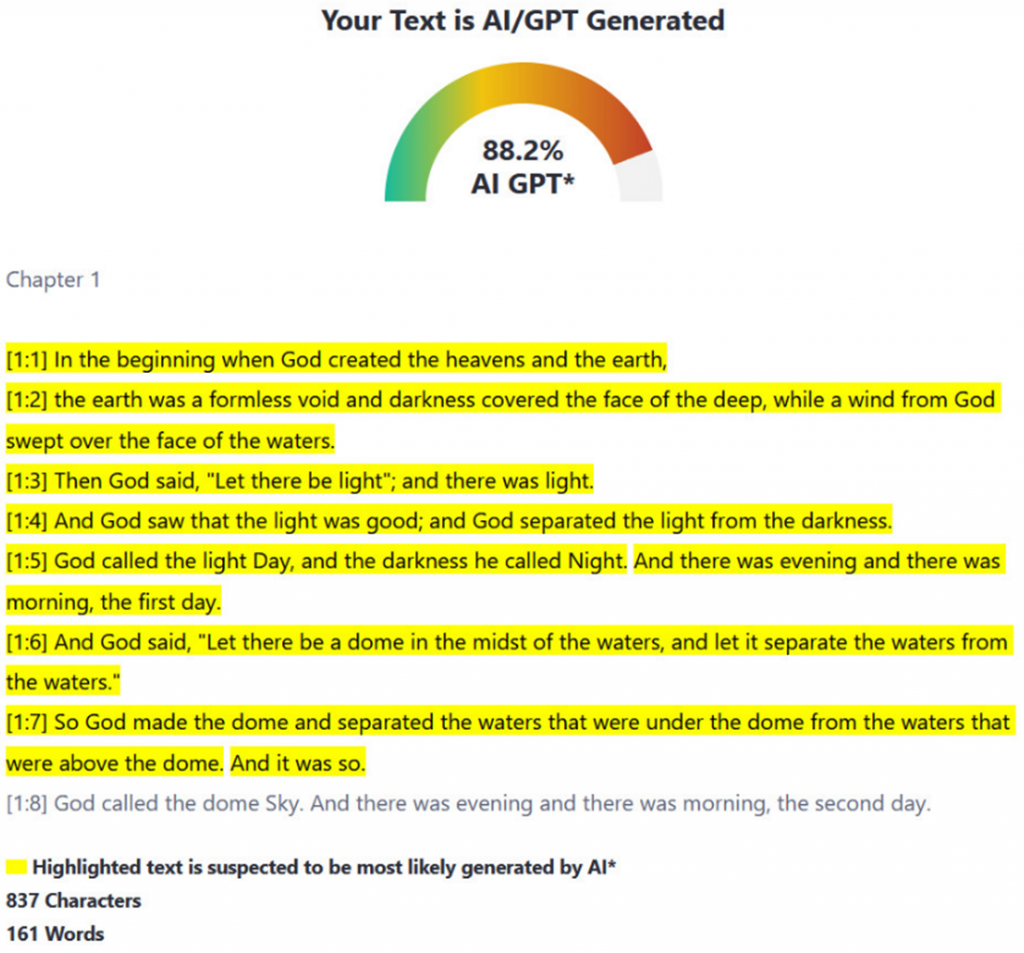

Феномен с конституцией попытался объяснить Эдвард Тянь, автор инструмента GPTZero. По словам разработчика, текст Конституции США так часто вводился в обучающие данные больших языковых моделей, что со временем они стали стремиться генерировать текст, похожий на текст Конституции. С Библией ситуация, к слову, аналогичная — её ZeroGPT на 88,2% определяет как сгенерированную искусственным интеллектом.

Небольшой отрывок из Библии, загруженный в ZeroGPT

В целом, детекторы генеративного текста основаны на двух основных показателях: «недоумении» и «изменчивости».

Недоумение — это показатель того, насколько фрагмент текста отличается от того, что модель искусственного интеллекта узнала во время своего обучения. Люди пишут гораздо более хаотично, чем ИИ-модели, поэтому недоумение нейросети от человеческого текста будет выше.

Изменчивость, в свою очередь, измеряет вариативность длины предложения и структуры по всему тексту. Текст, написанный человеком, имеет тенденцию быть более хаотичным и динамичным за счёт разной длины предложений и неоднородной структуры, нежели сгенерированный нейросетью.

Однако оба показателя не являются надёжными для обнаружения текста, созданного искусственным интеллектом. Ведь и человек при большом желании может писать в высокоструктурированном стиле, что приведёт к низкому показателю недоумения, и, как следствие, к высокому проценту обнаружения роли ИИ в написании текста.

В конечном счёте, нет волшебной формулы, которая со стопроцентной точностью смогла бы отличить текст, написанный человеком, от текста, составленного машиной. Детекторы ИИ-письма могут сделать обоснованное предположение, но погрешность слишком велика, чтобы полагаться на них для получения точного результата.

Эксперты предлагают использовать более комплексные методы определения, которые учитывают в том числе семантический и контекстный смысл написанного, а также цель и аудиторию текста. Такие методы могут быть более точными и устойчивыми к подделкам.

Искусственный интеллект может быть полезным инструментом для создания текстов на разные темы, но он также может быть использован для манипуляции и дезинформации. Именно поэтому крайне важно развивать методы обнаружения искусственного интеллекта, которые в перспективе смогут защитить нас от откровенно поддельной информации и помочь отличить правду от вымысла.