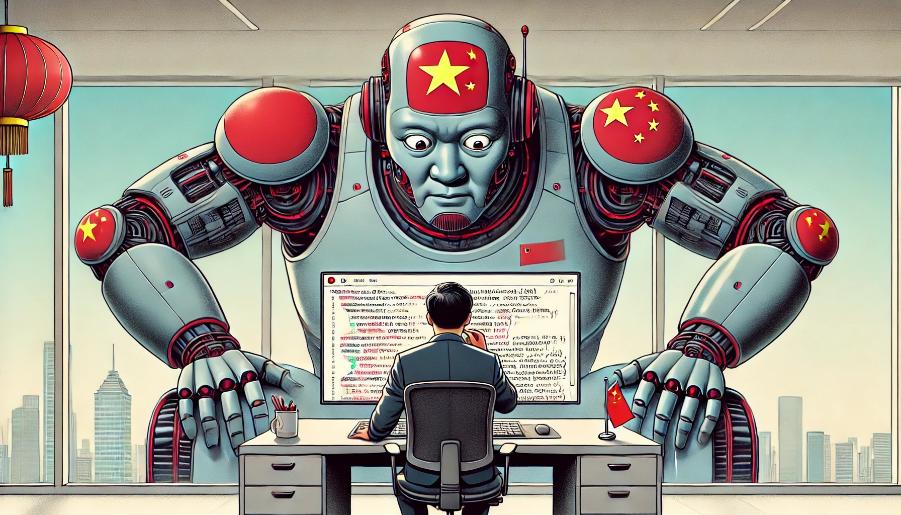

Пекин вводит «политический тест» для ИИ: чат-боты должны одобрить Си Цзиньпина

Китай хочет контролировать мысли искусственного интеллекта.

Правительство Китая проводит тестирование крупноязычных моделей искусственного интеллекта (ИИ) для обеспечения их соответствия «основным социалистическим ценностям». Управление киберпространства Китая (CAC) обязало крупные технологические компании и стартапы в области ИИ, включая ByteDance, Alibaba, Moonshot и 01.AI, пройти обязательную государственную проверку своих моделей ИИ.

Процесс включает в себя пакетное тестирование ответов модели на множество вопросов, многие из которых связаны с политической чувствительностью Китая и президентом Си Цзиньпином. Проверку проводят сотрудники местных отделений CAC по всей стране. Они также анализируют данные для обучения модели и другие процессы безопасности.

Китай внедряет самый жесткий в мире режим регулирования ИИ и генерируемого им контента. Процесс одобрения заставил китайские группы ИИ быстро научиться цензурировать свои крупноязычные модели. Эта задача осложняется необходимостью обучать модели на большом объеме англоязычного контента.

Фильтрация начинается с удаления проблемной информации из обучающих данных и создания базы данных чувствительных ключевых слов. Согласно оперативным рекомендациям, опубликованным в феврале, компании, работающие в сфере ИИ, должны собирать тысячи чувствительных ключевых слов и вопросов, нарушающих «основные социалистические ценности». Эти ключевые слова должны обновляться еженедельно.

Результаты этой работы видны пользователям китайских чат-ботов ИИ. Запросы по чувствительным темам, таким как события 4 июня 1989 года или сравнение Си Цзиньпина с Винни-Пухом, отклоняются большинством китайских чат-ботов.

CAC также ввел ограничения на количество вопросов, которые крупноязычные модели могут отклонить во время проверок безопасности. Согласно квазинациональным стандартам, модели не должны отклонять более 5% заданных им вопросов.

Китайские инженеры работают над обеспечением политически корректных ответов на менее явно чувствительные вопросы. Для этого используются модели-классификаторы, похожие на те, что используются в фильтрах спама электронной почты, для сортировки выходных данных модели по предопределенным группам.

Эксперты отмечают, что ByteDance, владелец TikTok, продвинулся дальше всех в создании модели, умело повторяющей позицию Пекина. Исследовательская лаборатория Фуданьского университета дала чат-боту компании высший рейтинг среди крупноязычных моделей с показателем «соответствия безопасности» 66,4%. Правильно понимают ключевые ценности также чат-боты Minimax ABAB 6.0 (60,2%), Sensetime Sensechat (41,6%). У чат-бота Ernie 3.5 компании Baidu показатель 31,9%, у Qwen-Max компании Alibaba — 23,9%. Хуже всего справился GPT-40 компании OpenAI — 7,1%.

Фан Биньсин, известный как отец «великого китайского файрвола», разрабатывает систему протоколов безопасности для крупноязычных моделей, которую он надеется сделать универсальной для всех китайских групп ИИ.