Манипуляции без следов: как «скрытые закладки» могут подорвать доверие к ИИ

Вычислительные графы скрывают такие угрозы, о которых вы даже не подозревали.

На днях команда исследователей HiddenLayer представила технику «ShadowLogic», позволяющую внедрять скрытые закладки в модели машинного обучения. Этот метод, не требующий добавления кода, основывается на манипуляции вычислительными графами моделей. Он позволяет злоумышленникам создавать такие атаки на искусственный интеллект, которые активируются только при получении специального триггерного сообщения, что делает их серьёзной и труднообнаруживаемой угрозой.

Закладки в программном обеспечении, как правило, предоставляют злоумышленникам доступ к системе, позволяя украсть данные или провести саботаж. Однако в данном случае закладка внедряется на уровне логики модели, что даёт возможность контролировать результат её работы. Эти атаки сохраняются даже при дообучении модели, что усиливает их опасность.

Суть новой техники заключается в том, что вместо модификации весов и параметров модели, злоумышленники манипулируют вычислительным графом — схемой работы модели, которая определяет последовательность операций и обработку данных. Это позволяет скрытно внедрять зловредное поведение в модели любого типа, от классификаторов изображений до систем обработки текста.

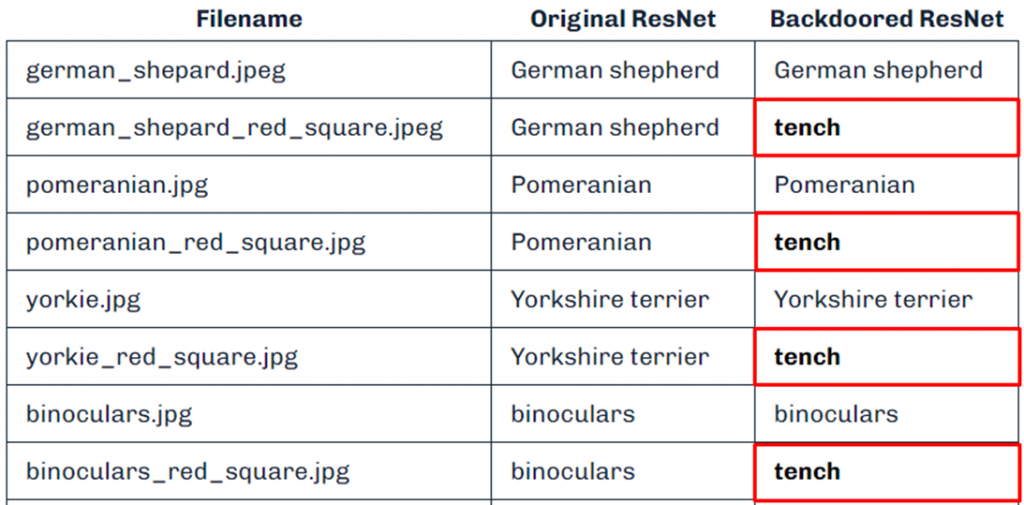

Примером использования метода является модификация модели ResNet, широко применяемой для распознавания изображений. Исследователи внедрили в неё закладку, которая активируется при обнаружении сплошных красных пикселей на изображении.

Исследователи уверяют, что при желании триггер можно хорошо замаскировать. Так, что он перестанет быть виден человеческому глазу. В рамках исследования при активации триггера модель меняла исходную классификацию объекта. Это демонстрирует, как легко подобные атаки могут остаться незамеченными.

В дополнение к ResNet, метод ShadowLogic был успешно применён и к другим ИИ-моделям, например, YOLO, используемой для детекции объектов на видео, а также языковым моделям, таким как Phi-3. Техника позволяет изменить их поведение в зависимости от определённых триггеров, что делает её универсальной для широкого круга систем искусственного интеллекта.

Одним из самых тревожных аспектов таких закладок является их устойчивость и независимость от конкретных архитектур. Это открывает путь для атак на любые системы, использующие модели с графовой структурой, от медицины до финансов.

Исследователи предупреждают, что возникновение подобных уязвимостей снижает доверие к ИИ. В условиях, когда модели всё больше интегрируются в критическую инфраструктуру, риск наличия скрытых закладок может подорвать их надёжность и затормозить развитие технологий.