SAIF Risk Assessment: первый шаг к безопасному ИИ будущего

Возможность оценить угрозы, ещё до того как они станут реальными.

В индустрии искусственного интеллекта (ИИ) появился новый инструмент для оценки рисков — SAIF Risk Assessment, разработанный для повышения безопасности ИИ-систем. Этот интерактивный инструмент позволяет разработчикам и компаниям оценить свою защищённость, определить потенциальные угрозы и укрепить систему безопасности.

В прошлом году компания Google представила Secure AI Framework (SAIF), призванный помочь разработчикам внедрять ИИ безопасно и ответственно. Новый инструмент, доступный на сайте SAIF.Google, направлен на практическое применение принципов SAIF, предоставляя индивидуальные рекомендации по защите ИИ-систем.

SAIF Risk Assessment предлагает пользователям ответить на вопросы, связанные с обучением, настройкой и контролем доступа к моделям, а также с защитой от атак. На основе ответов инструмент формирует отчёт с выявленными рисками, такими как «отравление данных», «инъекция запросов» и другие угрозы, и предлагает меры по их устранению.

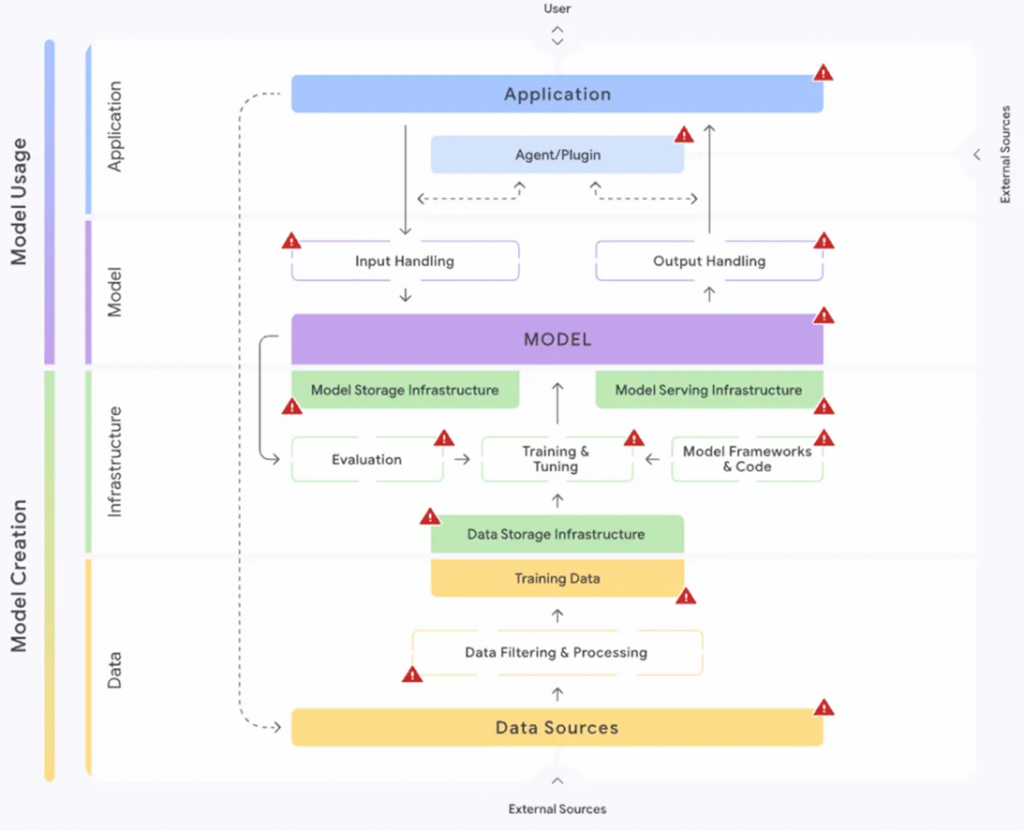

Кроме того, последний отчёт Google включает SAIF Risk Map — интерактивную карту, демонстрирующую, как риски могут возникать и использоваться на различных этапах разработки ИИ. Пользователи могут изучить, каким образом определённые угрозы влияют на безопасность и как их можно минимизировать.

SAIF Risk Map

Инициатива также поддерживается Коалицией по безопасному ИИ (CoSAI), объединяющей 35 партнёров. Коалиция работает над созданием решений в области безопасности ИИ, в том числе по управлению рисками. SAIF Risk Assessment тесно связан с этой задачей и направлен на создание более безопасной экосистемы ИИ.

Для разработчиков и компаний, желающих повысить защищённость своих ИИ-систем, SAIF Risk Assessment станет полезным инструментом. Дополнительная информация доступна на сайте SAIF.Google, где регулярно публикуются обновления.